Di creazioni e creatori

Uno dei temi più importanti della fantascienza è il rapporto tra noi e il diverso.

Un diverso che può essere visto sotto decine di forme: il classico alieno mostruoso dei film di fantascienza degli anni ’50, umani appartenenti ad altre fazioni come (per fare un esempio) in Gundam o nei romanzi di Heinlein e Asimov, computer senzienti come in 2001 Odissea nello Spazio o ancora Androidi/Robots, con tutte le possibili combinazioni intermedie a cui possiate pensare.

Anche il modo in cui questo diverso viene vissuto è stato sviscerato sotto praticamente qualunque ottica: se nei film di fantascienza classici di cui parlavo sopra avevamo mostri invasori il cui loro unico scopo era sterminare la razza umana (ma potremmo andare ancora più indietro toccando il buon H.G. Wells e la sua Guerra dei Mondi, per dire), già in contemporanea c’era un film come Ultimatum alla Terra (The day the earth stood still) il cui messaggio pacifista era notevole e moderno e, soprattutto, in netto contrasto con quanto in circolazione in quel momento.

Allo stesso modo, nel 1954, Fredrick Brown scrisse quel capolavoro di racconto breve che è il suo “Sentinella” e che giocava con la prospettiva del lettore (e della mente umana) in modo magistrale.

Uno degli argomenti, però, più affascinante è, secondo me, quello che viene toccato quando si va a parlare di Intelligenza Artificiale, Robot, Androidi.

Ovviamente il primo accostamento che viene in mente è con Isaac Asimov e le sue tre leggi della robotica: il buon zio Isaac, immaginando un futuro in cui i Robot fossero disponibili per quasi tutti tanto quanto un’automobile o un elettrodomestico, dotò le sue creature di tre semplici regole che garantissero la loro subordinazione ai creatori. Le, appunto, tre leggi della robotica a cui nessun cervello positronico, nell’universo Asimoviamo, avrebbe mai potuto disubbidire, al punto da rischiare di friggersi in situazioni di stallo.

- Un robot non può recar danno a un essere umano né può permettere che, a causa del proprio mancato intervento, un essere umano riceva danno.

- Un robot deve obbedire agli ordini impartiti dagli esseri umani, purché tali ordini non contravvengano alla Prima Legge.

- Un robot deve proteggere la propria esistenza, purché questa autodifesa non contrasti con la Prima o con la Seconda Legge.

Semplici. Geniali. E, si potrebbe pensare, estremamente comode: data la presenza di queste leggi, nessun robot potrebbe mai veramente essere considerato dotato di una propria coscienza o, le divinità non vogliano, paragonabile a un essere umano.

Se lo scopo di un robot è quello di servire, allora non può essere umano,

Non importa che lui possa ritenersi cosciente, non lo è.

Giusto?

E da qui nascono decine di domande che hanno alimentato la fantascienza fino a tutt’oggi, in un filone che sembra essere fonte inesauribile di narrative interessanti e interrogativi inquietanti.

Lo stesso Asimov giocò parecchio con l’argomento, un po’ inventando la legge zero, che metteva tutte le altre in una prospettiva molto più ambigua, un po’ seguendo la storia di un robot che voleva farsi dichiarare umano in un racconto poi sviluppato in romanzo (a quattro mani con Robert Silverberg) dal titolo Robot NDR 113.

Ma Asimov pose il seme, dicevo, un seme che è sbocciato e si è sviluppato negli anni ponendo la questione più importante di tutte: quanto noi, intesi come esseri umani, saremmo in grado di gestire la responsabilità della creazione?

Quanto saremmo disposti ad accettare che creature artificiali create da noi possano diventare autocoscienti e quindi trattate come nostre pari?

La risposta, come immaginerete, è quasi sempre pessimista e non possiamo certo dare torto a chi l’ha considerata tale: siamo una specie disposta a considerare inferiori o, addirittura, subumani suoi simili appartenenti a categorie varie, siano esse definite da religione, razza, colore della pelle, luogo di provenienza, gusti sessuali, sesso di nascita e via dicendo così; come possiamo davvero credere che saremmo sufficientemente responsabili e di mente aperta da accettare come nostri simili essere creati da noi? Accidenti, spesso i genitori stessi non riescono mai a considerare propri simili e pari i figli!

E questa domanda, con la relativa risposta, possiamo vederla alla base di molti classici di fantascienza più o meno recenti.

Pensate a Matrix: le macchine si sono ribellate perché gli umani le hanno rifiutate; non solo: sono stati gli umani a danneggiare irreversibilmente il pianeta sperando di distruggere la fonte di energia primaria delle macchine. Che, per sopravvivere, hanno reagito e hanno trovato una fonte alternativa: i loro stessi creatori.

Nello stesso Terminator si ha una situazione simile, magari più tagliata con l’accetta, ma la base è quella.

Ma ogni appassionato sa che l’esempio più fulgido di ciò di cui sto parlando è quel capolavoro recente dal nome Battlestar Galactica, dove i nostri figli, i Cylons, decidono di sterminarci perché li abbiamo ripudiati, perché (come dice il capitano Adama nel primo episodio) non ci siamo presi la responsabilità di ciò che abbiamo creato: ci siamo chiesti se fossimo in grado di farlo, mai se fossimo in grado di gestirlo.

E oggi, mentre vi scrivo, una nuova serie tv percorre questo impervio percorso di domande: Westworld.

L’idea di partenza, ispirata a un vecchio film di Michael Crichton, è che esistano robot in tutto e per tutto simili agli esseri umani che vengono utilizzati in un Parco a tema western con un solo scopo: essere oggetto di qualunque desiderio gli ospiti del parco abbiano.

Stupri? Nessun problema. Violenza? Accomodatevi pure. Omicidi? Torture? Perché no?

Tanto sono macchine, giusto? Tanto la loro memoria viene costantemente cancellata. Tanto non hanno coscienza. Tanto non hanno anima.

Quindi perché farsi scrupoli?

Loro esistono solo per il divertimento degli ospiti.

E se non fosse così?

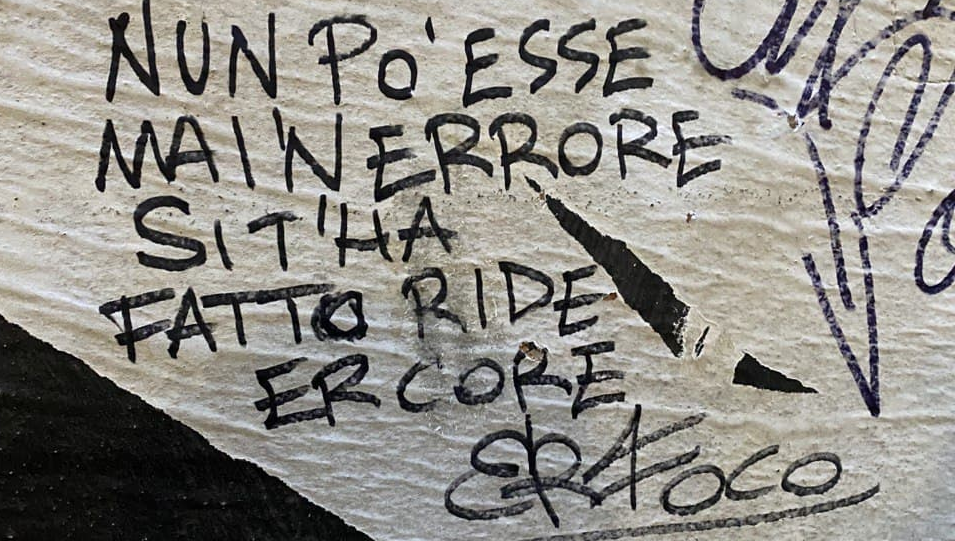

E se la coscienza fosse più forte dei limiti creati per contenerla? Se tanti piccoli errori portassero a una grande evoluzione? Succede in natura, d’altronde: l’evoluzione è la somma di tanti minuscoli errori.

E se, quindi, alla fine gli esseri umani fossero messi di fronte alle proprie responsabilità?

Non so se Westworld risponderà completamente e a modo suo a queste domande: manca un episodio alla fine della prima stagione e la scelta narrativa è stata quella di privilegiare la scoperta insieme ai protagonisti, siano essi host (come vengono chiamati i robots) o umani, mostrando quindi il solito problema secondo una nuova ottica e aggiungendo un ingrediente fondamentale nel piatto dello spettatore.

L’empatia.

Non comprensione, non ragionamento puro: empatia, condivisione di sentimenti ed emozioni, percezione della sofferenza altrui.

Ma questo altrui dovrebbe essere una macchina, il che fa esplodere in noi che guardiamo più domande che risposte, più dubbi che certezze.

Quella finale, più volte accennata qui sopra, presente in ognuno di questi viaggi narrativi non è “saremo mai in grado di costruire l’intelligenza artificiale”? La vera domanda è “saremo mai in grado di gestire le conseguenze dell’esistenza di una tale intelligenza?”.

E la risposta è, terribilmente e profeticamente, una sola.

No.